熊野創一郎さん(博士課程)と山崎俊彦教授(ともに東大大学院情報理工学系研究科)らの研究チームは、人工知能(AI)を安全に機能させるにはAIに備わるニューラルネットワークの「幅」を広げることが重要であることを明らかにした。成果は12月10日から16日にかけて米国で開催された国際会議「Conference on Neural Information Processing Systems (NeurIPS)」で発表された。

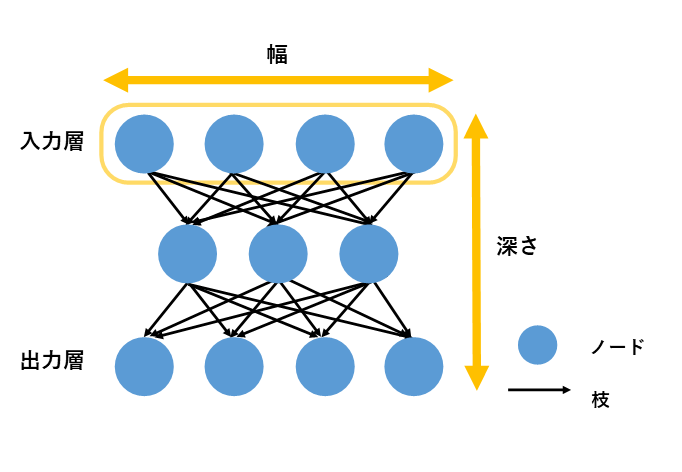

ニューラルネットワークは、脳の神経回路を模した情報処理網。最小単位の「ノード」は入力信号を変換する。その信号がノードから生えたさまざまな接続強度を持つ枝を通じて他のノードに伝達することで情報処理を行う。ネットワークの性質を決めるのは、一つの層に並列されたノードの数を表す「幅」と層の数を表す「深さ」。学習を通じてニューロン間の幅や深さを変化させ、的確な応答が可能になる。近年のAI技術である深層学習は、ノードが並列した層の積み重ねを多くすることで高い性能を発揮する(図)。 「敵対的事例」はAIに誤った挙動を引き起こす学習内容。敵対的訓練では、敵対的事例と正常なデータとの比較学習でAIの持つネットワークを変化させる。結果、敵対的事例に対しても正しい挙動を起こせるようになることが知られている が、そのメカニズムには不明な点が多かった。

今回の研究では、「平均場理論」に注目して敵対的訓練の解析を行った。これはネットワークの幅が十分に大きいとき、ネットワーク内のノードから出力される値 の分布が正規分布に従うという仮定の下で構築する理論 。ネットワークの特性を明らかにし、性質を改善する見通しを立てることができる。従来の平均場理論では、出力値の入力値への依存具合も不明 で、一部の特性しか分からず、敵対的訓練でのネットワーク変化の解析ができなかった。

熊野さんらは、ノードでの情報処理法を改めた新たな平均場理論を提案。出力値の分布が入力値に依存されず、ネットワーク全体を解析することが可能になった。この理論の下で敵対的訓練を用いて解析したところ、ネットワークの層の数ではなく、1層のネットワークの幅が広い方が敵対的攻撃への耐性を獲得しやすいことが分かった。多様なニューラルネットワークでも同様の性質が確認された。

敵対的訓練は、AIを悪意ある攻撃から守るための有効な予防策だとされている。今回の成果は、安全なAI開発に貢献するほか、深層学習全般の解析の進歩にもつながると期待される。